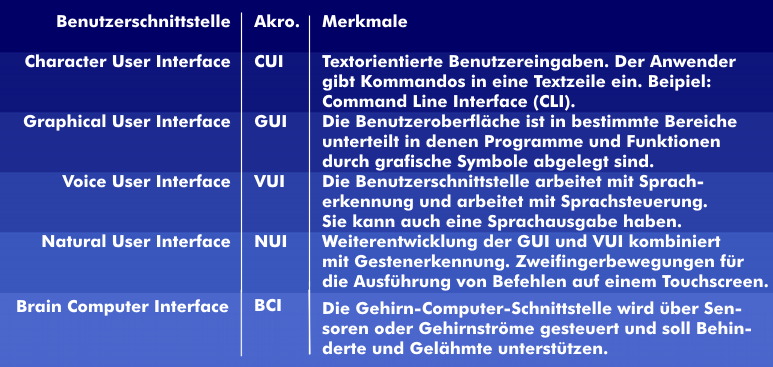

Die Mensch-Maschine-Schnittstelle bestimmt die Art und Weise wie Mensch und Maschine unmittelbar miteinander kommunizieren, wie der Mensch seine Anweisungen an die Maschine übermittelt und in welcher Form diese die Anweisungen ausführt und die Ergebnisse ausgibt. In den Anfangsjahren der Computertechnik waren die Benutzereingaben textorientiert. Der Bedienende musste spezielle Kommandos eingeben, die vom Betriebssystem interpretiert wurden. Die Schnittstelle nannte sich früher Character User Interface (CUI).

Die bisherigen HMI-Technologien arbeiten mit visueller Interaktion: Der Bedienende aktiviert eine Eingabe und sieht als interaktive Rückmeldung die Ausführung auf dem Bildschirm. Selbst bei Touchscreens mit denen der Bedienende unmittelbar in Berührung steht, wird lediglich die Funktionsausführung auf dem Display angezeigt.

Anders erfolgt die Interaktion beim Betätigen von mechanischen Komponenten. Wird ein Druckknopf oder Taster bedient, dann erfolgt die unmittelbare Interaktion über die Fingerspitzen in Form eines Gegendrucks. Diese Interaktion sollen Touchscreens mit haptischer Simulation übernehmen. Bei dieser Technik bewegt sich die Bildschirmoberfläche. Drückt der Bedienende auf eine Funktionstaste, dann erfolgt eine kurzzeitige vertikale Bewegung des Bildschirms, die von der Fingerkuppe wahrgenommen wird. So wird das Gefühl eines echten Tastendrucks simuliert.

Die vertikale Bewegung der Bedienoberfläche kann durch verschiedene Verfahren realisiert werden: Mit elektromagnetischen Aktoren, elektrostatischen Feldern oder mittels Piezoeffekt.

Bedienungsfreundlichkeit des Human Machine Interface

Der Erfolg eines technischen Produktes hängt nicht nur von den Faktoren Preis, Zuverlässigkeit und Lebensdauer ab, sondern auch vom Faktor Handhabbarkeit bzw. Bedienungsfreundlichkeit (Usability). Idealerweise erklärt sich ein Human Machine Interface (HMI) intuitiv von selbst, also ohne Schulungsaufwand. Der Lichtschalter ist trotz seiner Beliebtheit und Einfachheit keine ideale Benutzerschnittstelle, sondern der Kompromiss eines Zielkonflikts. Dieser besteht darin, dass der Schalter einerseits direkt am einzuschaltenden Gerät angebracht sein sollte, also an der Lampe selbst (damit man ihn nicht suchen muss). Andererseits sollte er in der Nähe der Tür sein (wo er in der Regel auch ist), damit man nicht im Dunklen erst nach der Lampe tasten muss. Eine ebenso beliebte, aber auch nicht ideale Schnittstelle ist der berührungsempfindliche Bildschirm: Hier ruft man zum Beispiel durch Berühren des Bildschirmsymbols für E-Mail das Programm auf, welches die E-Mail abholt. Während man jedoch auf das Icon drückt, verdeckt der Finger das Icon selbst. Dies schafft in der Regel keine Probleme, aber das präzise Malen oder Schreiben mit Fingern auf dem Bildschirm ist unmöglich.

Evolution von Human Machine Interfaces (HMI)

Bei langlebigen Produkten werden im Laufe der Jahre die Human Machine Interfaces (HMI) optimiert. So fehlen heute bei Abspielgeräten für Audio oder Video zwei Schalter, die noch in den 1980er Jahren üblich waren: Die Funktionalität der Schalter für den Sprung zum vorhergehenden oder nächsten Take wurden in die Schalter für schnelles Vor- oder Zurückspulen integriert. Dafür wurde die Benutzerschnittstelle komplexer, weil jeder der beiden Knöpfe nun zwei Funktionen erfüllt. Bei den Entwicklern von Benutzerschnittstellen spielt die Reduktion wie in diesem Beispiel eine zentrale Rolle: Die Reduktion des Zugangs zu einer komplexen Maschine auf nur wenige Bedienungselemente mag die grundsätzliche Bedienbarkeit erleichtern, wird aber meist der Komplexität nicht gerecht. Bei den sehr komplexen Betriebssystemen moderner Computer löst man diesen Zielkonflikt durch zwei Kategorien von Benutzerschnittstellen/Human Machine Interfaces (HMI): Die eine zeigt dem Anwender für den Alltag die Icons, den Papierkorb, die Ordner usw., die er ohne Lernaufwand sofort versteht und bedienen kann: Der Klick auf einen Link zum Beispiel öffnet die Ziel-Webseite. Die andere ermöglicht ihm über die Kommando -zeilenoberfläche einen tiefen Eingriff in das Computersystem, erfordert jedoch einen hohen Lernaufwand. So beendet etwa taskkill /F /IM iexplore.exe alle mit dem Internet Explorer zusammenhängenden Prozesse auf einem Windows-System.

Brain-Computer-Interface

Ein Brain-Computer-Interface (BCI), auch Brain-Machine-Interface (BMI), deutsch Gehirn-Computer-Schnittstelle (manchmal auch Hirn-Maschine-Schnittstelle, Rechner-Hirn-Schnittstelle), ist eine spezielle Mensch-Maschine-Schnittstelle, die ohne Aktivierung des peripheren Nervensystems, wie z. B. die Nutzung der Extremitäten, eine Verbindung zwischen dem Gehirn und einem Computer ermöglicht. Dazu wird entweder die elektrische Aktivität aufgezeichnet (nichtinvasiv meistens mittels EEG oder invasiv mittels implantierter Elektroden) oder die hämodynamische Aktivität des Gehirns gemessen (mittels fMRI oder NIRS) und mit Hilfe von Rechnern analysiert (Mustererkennung) und in Steuersignale umgewandelt. Das BCI stellt eine Anwendung der Neurotechnik dar.

Tangible User Interface

Ein Tangible User Interface ist eine anfassbare Benutzerschnittstelle, die einem Computerbenutzer die Interaktion mit der Maschine durch physische Objekte erlaubt. Oftmals wird auch das Akronym TUI verwendet (engl. Tangible User Interface). Die Bezeichnung “Graspable User Interface” wurde in einigen initialen Arbeiten verwendet, wurde aber später vollständig durch “Tangible User Interface” verdrängt. Im deutschen Sprachraum werden auch die Begriffe „Gegenständliche Benutzerschnittstelle“ sowie „Begreifbare Interaktion“ synonym verwendet.

Grafische Benutzeroberfläche

Grafische Benutzeroberfläche oder auch grafische Benutzerschnittstelle (Abk. GUI von englisch graphical user interface) bezeichnet eine Form von Benutzerschnittstelle eines Computers. Sie hat die Aufgabe, Anwendungssoftware auf einem Rechner mittels grafischer Symbole, Steuerelemente oder auch Widgets genannt, bedienbar zu machen. Dies geschieht bei Computern meistens mittels einer Maus als Steuergerät, mit der die grafischen Elemente bedient oder ausgewählt werden, bei Smartphones, Tablets und Kiosksystemen in der Regel durch Berührung eines Sensorbildschirms.

Die Gesamtgestaltung heutiger grafischer Oberflächen verwendet oftmals die sogenannte Schreibtischmetapher. Dieses Konzept wurde ab 1984 mit dem Macintosh von Apple populär, in den 1990er Jahren entwickelte es sich zum Industriestandard bei Personal Computern.

Natural User Interfaces (NUI)

Natural User Interfaces (NUI) oder „Reality Based User Interfaces“ ermöglichen dem Nutzer eine direkte Interaktion mit der Bedienoberfläche durch Wischen, Tippen, Berühren, Gesten oder Sprache. Natürliche Benutzungsoberflächen wie Touchscreens sind berührempfindlich und reagieren auf Finger- und Handbewegungen. Man spricht in diesem Zusammenhang auch von gestenbasierter Bedienung.

Durch die Entwicklung von Touchscreens haben sich die bisherigen Bedienmuster von grafischen Oberflächen (GUI) stark verändert. Während bisher künstliche Eingabegeräte, wie eine Tastatur oder eine Maus zur Interaktion nötig waren, genügt nun eine Fingerberührung. Viele Smartphones, Tablets, aber auch Fahrkartenschalter oder Bankautomaten und andere Geräte nutzen diese direkte Form der Bedienung.

Da das Berühren und Beeinflussen der virtuellen Objekte nahezu in gleicher Weise wie das realer Objekte funktioniert, fällt es Nutzern leicht, Handlungen aus dem Alltag in das digitale System zu übertragen. Durch Handlungen in der realen alltäglichen Umwelt können Parallelen zu den virtuellen Objekten gezogen und Handlungsweisen übertragen werden. Es werden also bereits bestehende Wissensstrukturen aktiviert und Vorwissen angewandt. Die Entwicklung weg von Eingabegeräten wie einer Maus und hin zu Multi-Touch bringt die reale und die virtuelle Welt näher zusammen. Objekte werden nicht mehr durch Befehle an den Computer beeinflusst, sondern selbst in die Hand genommen. Dieser Ansatz wird ‘Reality-Based Interaction’ (RBI) genannt und dient als Grundlage für die Gestaltung von Multi-Touch-Applikationen.

Verschiedene vorbestimmte Interaktionsmöglichkeiten, sogenannte ‘patterns’, wie zum Beispiel das Skalieren, Verschieben und Drehen von Bildern oder das Scrollen von Informationen, erlauben es dem Nutzer mit dem Gerät und der Software direkt über das Interface zu agieren.

NUI ermöglicht dem Menschen einen sehr viel natürlicheren Umgang mit Interaktionen und bedeutet eine Erweiterung des bisher beschränkten künstlichen Umgangs mit technischen Interfaces.

Stimmliche Benutzerschnittstelle

Der Begriff Stimmliche Benutzerschnittstelle (SBS, engl. voice user interface, VUI) bezeichnet in Anlehnung an eine grafische Benutzeroberfläche die Benutzerschnittstelle von Sprachdialogsystemen.

Die Ein- und Ausgabe erfolgt hierbei über gesprochene Sprache. Hierfür werden weder die Hände benötigt, noch muss ein Display beobachtet werden. Haupteinsatzgebiete sind neben dem Telefoniebereich in Form von IVRs Smartphones mit ihren persönlichen Assistenzsystemen wie etwa Siri oder Google Now.

Durch ein günstiges Dialog Design versucht man die Vorteile einer Stimmlichen Benutzerschnittstelle zur Geltung zu bringen und dessen Beschränkungen abzumildern.

Radical Atoms

„Radical Atoms“ gehören zu den TUIs und können sogar als eigene Art von Benutzeroberflächen aufgefasst werden. Ursprüngliche Konzepte waren bereits 1999 in Entwicklung.