1 Einleitung

Informatik ist die „Wissenschaft von der systematischen Darstellung, Speicherung, Verarbeitung und Übertragung von Informationen, besonders der automatischen Verarbeitung mithilfe von Digitalrechnern“. Historisch hat sich die Informatik einerseits als Formalwissenschaft aus der Mathematik entwickelt, andererseits als Ingenieursdisziplin aus dem praktischen Bedarf nach der schnellen und insbesondere automatischen Ausführung von Berechnungen.

2 Die Vorgeschichte

Die Informatik treibt die Entwicklung von Wissenschaft und Technik voran und ist selbst Produkt dieser Entwicklung.

Dabei sind 3 Fachgebiete prägend :

– Mathematik, insbesondere die numerischen Methoden

– Mechanik, insbesondere die mech. Rechenmaschinen

– Elektronik, insbesondere die Transistortechnik und Mikroelektronik

Eines der ältesten Rechenhilfsmittel ist der sog. ABAKUS, welcher um ca. 1100 v.u.Z. in Ostasien erfunden wurde. Es handelt sich dabei um ein leicht zu bedienendes Speichergerät für Zwischenergebnisse einer Rechnung.

Die erste mechanische Rechenmaschine konstruierte der deutsche Professor Wilhelm Schickardt im Jahr 1623. Mit Hilfe von verschiebbaren Rechenstäben konnten alle vier Grundrechenarten durchgeführt werden. Das Original der Maschine ist abgebrannt, so blieb Schickardts Arbeit ohne Einfluss auf die weitere Entwicklung.

Blaise Pascal stellte 1642 seine Rechenmaschine der Öffentlichkeit vor.

Dieser Zweispeziesrechner ähnelt der Rechenuhr Schickardts hinsichtlich der Konstruktion.

Gottfried Wilhelm Leibniz setzte dem eins drauf und konstruierte 1671 den Vierspeziesrechner, mit der alle 4 Grundrechenarten durchführbar waren.

Die eigentlichen geistigen Begründer der heutigen Computer waren der Engländer Charles Babbage und der Deutsch-Amerikaner Hermann Hollerith.

Von 1822 – 1832 entwarf Charles Babbage den ersten digitalen programmgesteuerten Rechenautomaten, genannt ,,Analytical Engine“.

Der Entwurf dieser Maschine war revolutionär. Sie verfügte über alle Funktionseinheiten heutiger Computersysteme. Diese dampfbetriebene Maschine sollte mit Bolzen, Zahnrädern, Zylindern u.a. mechanischen Teilen arbeiten und war in der Lage, eine Kette von verwandten Rechnungen durchzuführen.

Babbage erkannte als erster, dass eine einzige Maschine einer Reihe verschiedener Zwecke dienen kann.

Hermann Hollerith entwickelte 1886 die erste elektrisch arbeitende Lochkartenmaschine. Die große Bewährungsprobe kam mit der Volkszählung 1890 in den USA. Statt 7 Jahre dauerte die Auswertung mit Hollerith´s Lochkartenmaschine nur noch 4 Wochen.

3 Das 20. Jahrhundert

Von 1934 bis 1941 baute Konrad Zuse die ersten funktionsfähigen programmgesteuerten Rechenautomaten Z1, Z2 und Z3.

Sie funktionierten aufgrund einer Relaistechnik. Konrad Zuse führte somit das Dualsystem in die Rechentechnik ein.

Die Z1 baute Zuse noch aus rein mechanischen Elementen mit geringen Hilfsmitteln. Während diese, seine erste Maschine, nur teilweise funktionierte, arbeitete die Z3 schon ohne Fehler. Sie wurde im Auftrag der Deutschen Versuchsanstalt für Luftfahrt im Jahr 1941 fertiggestellt und verfügte über ein Rechenwerk mit 600 Relais und einen Speicher mit 2000 Relais. In einer Minute konnte diese Maschine bis zu 50 Operationen bewältigen. Das Originalgerät der Z3 ist im Krieg verloren gegangen, das Deutsche Museum in München besitzt aber eine Rekonstruktion.

Im Jahre 1943 wurde in Großbritannien der erste elektronische Digitalcomputer namens ,,Colossus“ erbaut unter der Leitung des brit. Mathematikers Alan Mathison Turing.

In den USA entwickelte der Harvard-Professor Howard A. Aiken 1945 den ,,MARK I“. Diese Rechenanlage wurde unter strengster Geheimhaltung in Zusammenarbeit mit der Harvard-Universität und der Firma IBM entwickelt.

Obwohl Aiken weder von Babbage noch von Zuse wusste, glich der Aufbau seiner Maschine dem der Maschinen von Konrad Zuse und dem Plan von Babbage.

Ein großer Unterschied bestand allerdings in der äußeren Form:

Im Gegensatz zur relativ kleinen Z3 war der MARK I mit seinen 15m Länge und 2,5m Höhe ein Gigant und wurde auch als das ,,Monstrum von Cambridge“ bezeichnet.

Ein weiterer Unterschied war, dass der 2500 Mark teure Z3 bis zu 20 arithmetische Operationen in der Sekunde durchführen konnte, der MARK I allerdings 400000 Dollar kostete und lediglich 3 Additionen pro Sekunde zustande brachte.

Die Entwicklung ging in den Vereinigten Staaten sehr schnell voran und so kam es schon 1 Jahr später, also 1946, zur Inbetriebnahme des ENIAC [Electronical Numerical Integrator and Calculator], dem ersten Rechenautomaten, der rein elektronisch arbeitete. Geschaffen wurde diese Anlage von den beiden US-Wissenschaftlern J.P.Eckert und J.W.Mauchly.

Das wesentlich neue Bauelement war die Elektronenröhre oder auch als Triode bezeichnet. Mit 18000 Röhren war der ENIAC 200mal schneller als der MARK I, kostete dafür allerdings 20 Mio. Dollar und brachte stolze 30 Tonnen auf die Waage.

Aufgrund der Entwicklung neuer Bauelemente waren die Computer Mitte der 50er Jahre bereits 1000mal schneller als der ENIAC. Grund dafür waren u.a. kürzere Leitwege für den elektrischen Strom, die zu schnelleren internen Rechenzeiten führten.

4 Computergenerationen

Aufgrund der rasch folgenden technischen Revolution wurden bis heute 5 Computergenerationen entwickelt.

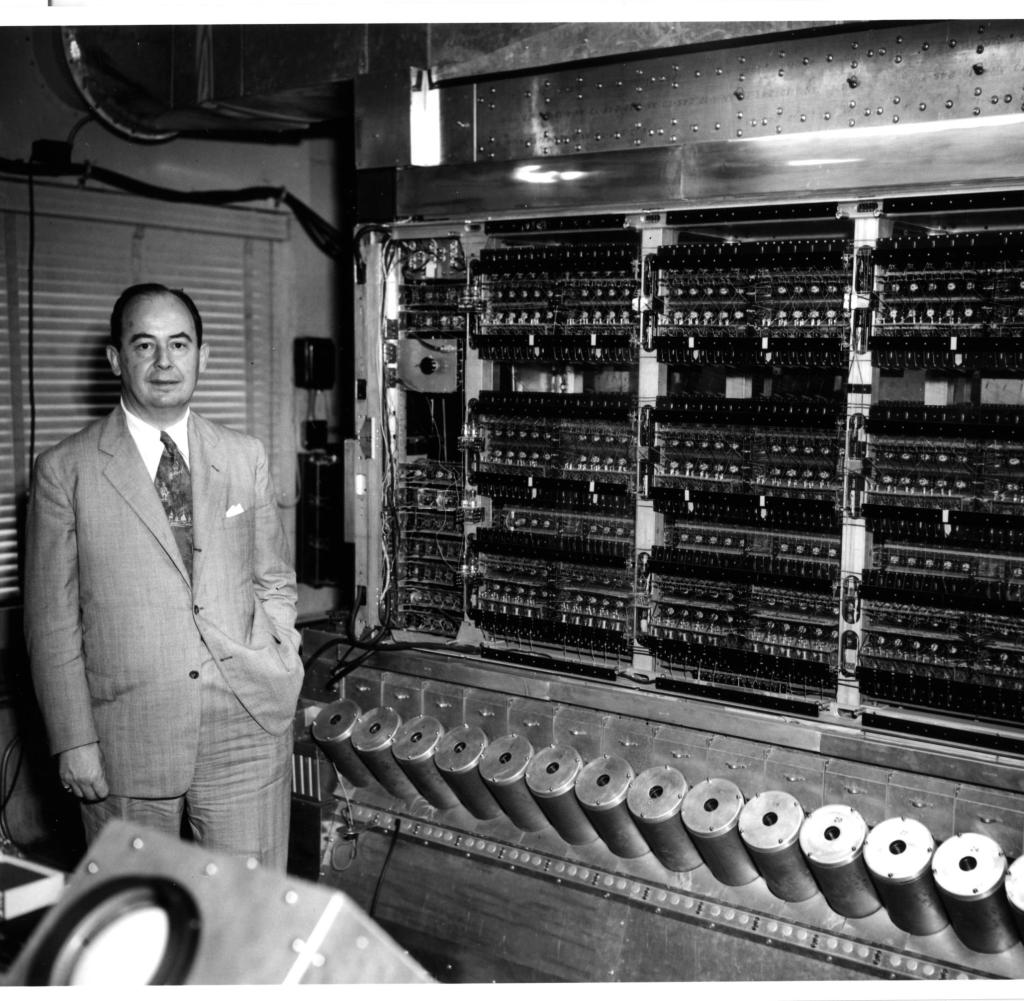

Die 1. Generation ab 1952 war vorwiegend mit Elektronenröhren ausgestattet, wobei die Röhren durch Kilometer von manuell verdrahteten Leitungen miteinander verbunden waren und die Anlagen dadurch sehr kostspielig waren und viel Raum benötigten.

Diese Rechner schafften etwa 1000 Additionen pro Sekunde, die Programmierung erfolgte über Maschinencode und eingesetzt wurden sie hauptsächlich für wissenschaftlich-technische Berechnungen.

Die 2. Generation existierte ab 1960 und wurde durch die Revolution der

Transistoren, die die Röhren ersetzten, hervorgerufen.

Zudem ersetzten gedruckte Schaltungen die meisten Kabel und Verdrahtungen, wodurch die Computer wesentl. kleiner und vorallem schneller wurden. Sie schafften bis zu 1000 Additionen pro Sekunde.

Bei der 2. Generation verwendete man eine einfachere, symbolische Programmiersprache, die Assemblersprache.

Außerdem wurden die ersten problemorientierten Programmiersprachen entwickelt: FORTRAN (1958) sowie ALGOL 60 und COBOL (1960)

Die Rechner der 2. Generation wurden u.a. als Prozessrechner und als kommerzielle Rechner eingesetzt.

Die Verwendung von SLT (Slid Logic Technology), eine von IBM entwickelte Mikroschalttechnik, brachte Mitte der 60er Jahre die 3. Generation hervor. Durch die winzigen, integrierten Schaltkreise konnten die Arbeitsleistungen der Computer enorm verbessert werden, sodass 500000 Additionen pro Sekunde möglich waren.

In der 3. Generation wurden die Abmessungen und Kosten derartig gesenkt, dass die Computer universell einsetzbar waren.

Die 4. Generation, die es seit ca. 1970 gibt, wurde durch die Technologie der Mikroelektronik geprägt. Man verwendete u.a. hochintegrierte Schaltkreise, sog. Mikroprozessoren, und Speicherchips, wodurch eine Geschwindigkeit von ca. 10 Mio. Additionen pro Sekunde ermöglicht wurde. Bei der 4. Generation handelte es sich um Rechnernetze mit hoher Kommunikationsfähigkeit, die sowohl im öffentlichen als auch im privaten Bereich einsetzbar waren.

Bei der 5. Generation, die es seit Anfang der 80er Jahre gibt, verwendet man höchstintegrierte Schaltkreise. Durch die Miniaturisierung und größere Packungsdichte werden Geschwindigkeiten von 100 Mio. Additionen pro Sekunde erreicht.

Seit den 90er Jahren hat man sich das Ziel gesetzt, die Expertensysteme zu vervollkommnen und die Systeme durch künstliche Intelligenz, Spracherkennung und Parallelisierung weiterzuentwickeln.

Die Grundlage dafür bilden höchstintegrierte Schaltkreise mit mehreren Prozessoren auf einem Chip.

Das Computerzeitalter hat erst begonnen und die Entwicklung steht nicht still.

5 Informatik in der Zukunft

Also Ray Kurzweil, ein Zukunftsforscher, geht davon aus, dass die Entwicklung sich ständig beschleunigt, bis zu einem Ereignis um 2040, das er die Singularität nennt. Da passiert quasi alles auf einmal und es ist unmöglich vorherzusagen, was danach passieren wird. Er vermutet etwa, dass wir irgendwann nur noch virtuell leben, indem wir unser Gehirn virtuell abbilden und in ein Rechnernetz einspeisen, oder so ähnlich.

Die Informatik wird weitere Teile des Lebens bestimmen und den Menschen aus manchen Bereichen vollständig verdrängen. Fahrzeuge werden etwa irgendwann nur noch computergesteuert werden, ist ja auch viel sicherer und bequemer. In allen möglichen Gegenständen werden Mikroprozessoren untergebracht sein, die ihre Energie aus Vibrationen beziehen. Diese steuern zum Beispiel alles möglich im Haus, die Beleuchtung, die Belüftung… Es wird Roboter geben, die den Menschen (zuerst einmal ältere) bei alltäglichen Aufgaben unterstützen. Ein weiterer Zukunftsforscher hat vorausgesagt, dass 2050 eine Roboter-Mannschaft den aktuellen Fußball-Weltmeister schlagen wird. Viele Produktionsprozesse werden Robotern überlassen werden, auch einige Dienstleistungsbereiche. Vielleicht werden sogar Roboter Krieg führen (ist ja mit Drohnen schon teilweise der Fall). Und weil Informatiker immer bestimmender wird, werden Computerviren auch gefährlicher und der Schutz der eigenen Netze immer bedeutsamer.

Das waren ein paar Vermutungen von Zukunftsforschern, die die allgemeine Richtung andeuten sollen. Vielleicht kommt aber auch alles ganz anders.

6 Resümee

Mir hat es sehr gefallen, mich mit dem Thema auszusetzten da ich großes Gefallen in geschichtsträchtigen Ereignissen habe. Außerdem war es mir wichtig zu erfahren, wie es mit der Informatik angefangen hat, was die Meilensteine waren.

7 Quellenverzeichnis

https://www.lerntippsammlung.de/Die-Geschichte-der-Informatik.html

https://www.gutefrage.net/frage/informatik-in-der-zukunft